第一部分:從知識淵博到樂於助人

一個基礎的大型語言模型(LLM),在其初始訓練完成後,儲存了來自網際網路的大量資訊。它能夠存取和重現這些資訊,但在本質上,它只是一個根據統計機率預測下一個詞的系統。這意味著,雖然它知識淵博,但它天生並不知道如何以一種對使用者有幫助、安全且符合人類期望的方式進行溝通。

例如,對於一個簡單的問題,基礎模型可能會給出一個事實正確但過於複雜、不相關或格式混亂的答案。它缺乏對話的上下文、使用者意圖的理解以及判斷何為「好」答案的能力。

為了解決這個問題,研究人員開發了一套名為「人類回饋增強學習」(Reinforcement Learning from Human Feedback, RLHF)的訓練流程。RLHF的目的不是向AI灌輸新知識,而是一個行為校準過程。它旨在約束和引導AI,使其學會如何以一種更專注、更符合人類價值觀的方式來運用其已有的龐大知識庫。這個過程的核心,是塑造AI的行為,而非增加其知識。

第二部分:三步驟訓練流程概覽

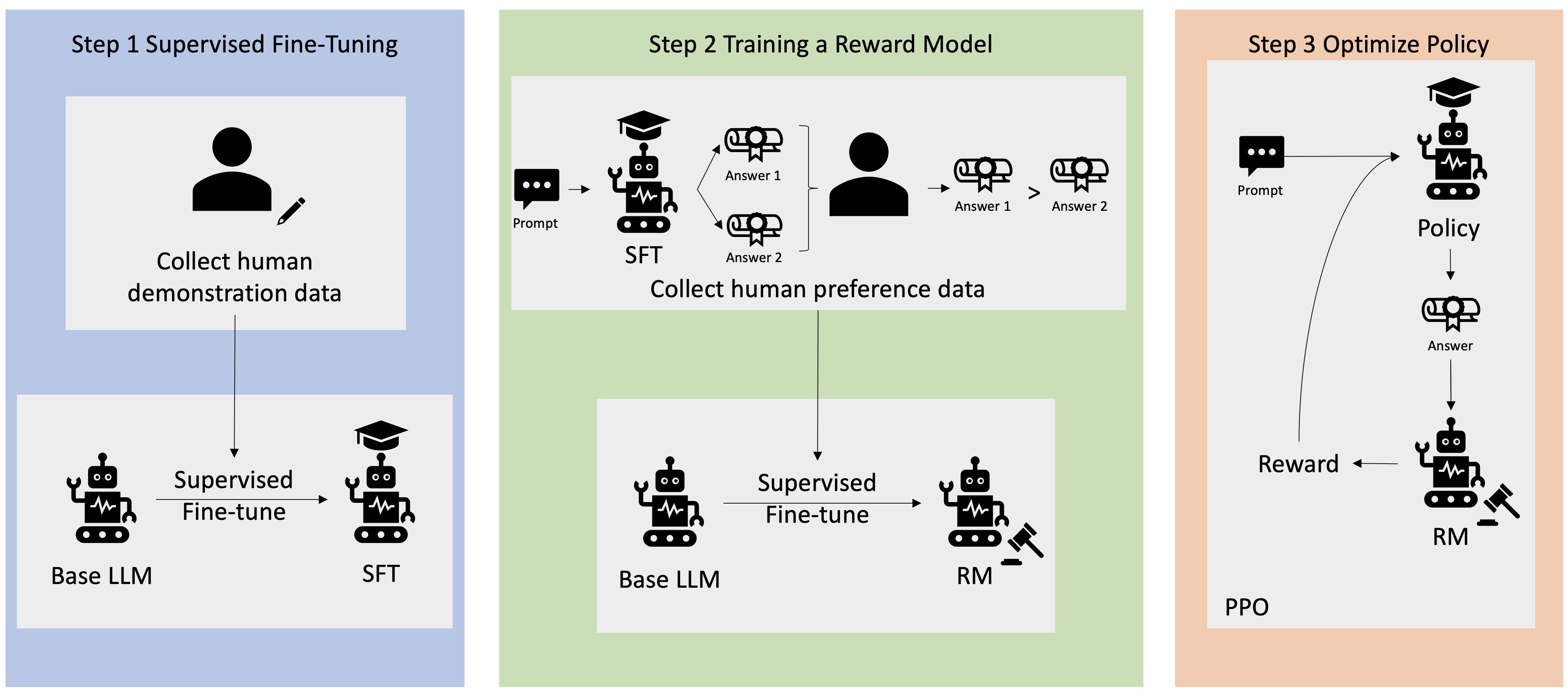

RLHF主要由三個核心階段構成,每個階段都建立在前一個階段的基礎之上,系統性地將一個原始的基礎模型轉變為一個經過對齊(aligned)的AI助理。

這三個步驟分別是:

- 監督式微調 (Supervised Fine-Tuning, SFT):AI學習模仿由人類專家撰寫的高品質答案範例。

- 獎勵模型建構 (Reward Model, RM):訓練一個獨立的AI,讓它學會像人類一樣判斷答案的品質,並為答案打分。

- 增強學習 (Reinforcement Learning, RL):主AI模型透過不斷嘗試和獲取獎勵模型的分數,來優化自己的回答策略,以產生能獲得最高分的答案。

下方的表格總結了整個訓練流程中每個階段的任務、輸入與輸出。

表格一:RLHF訓練流程總覽

| 訓練階段 | 目標 | AI的簡化工作內容 | 輸入(提供什麼給它) | 輸出(它產生什麼) |

| 1. 範例學習 (監督式微調) | 讓AI學習高品質回答的基本格式與風格。 | 主AI學習模仿高品質的人類撰寫答案。 | 一個問題(提示)。 | 一個由人類撰寫的理想答案。 |

| 2. 建立「做得好!」計分卡 (獎勵模型建構) | 訓練一個能自動評估答案品質的評分系統。 | 第二個「評審」AI學習根據人類的偏好來給答案打分。 | 一個問題 + 兩個由AI生成的不同答案。 | 一個人類選擇的「更好」的那個答案。 |

| 3. 練習、回饋與進步 (增強學習) | 讓主AI根據評分系統的回饋進行自我優化。 | 主AI嘗試用一種能從「評審」AI那裡獲得最高分的方式來回答問題。 | 一個新的問題。 | 一個AI認為「評審」會喜歡的、經過改進的答案。 |

匯出到試算表

第三部分:第一步 – 監督式微調 (SFT)

訓練的第一步是監督式微調(Supervised Fine-Tuning, SFT)。這個階段的目標是為AI提供一個高品質對話的「基線」或「行為範本」。

這個過程首先需要創建一個高品質的示範數據集 “。人類標註員(通常是經過訓練的專家)會針對各種提示(prompts)撰寫理想的回應。這些提示涵蓋了廣泛的主題和任務,而回應則被精心設計,以確保其準確性、幫助性、無害性和恰當的風格。

- 輸入(Input):一個提示,例如「解釋什麼是光合作用」。

- 輸出(Output):一份由人類專家撰寫的、清晰且易於理解的回應。

這個由數萬個「提示-回應」配對組成的數據集,被用來對基礎LLM進行微調。模型透過學習這些範例,調整其內部參數,以模仿人類專家的寫作風格、回答結構和語氣。這個步驟為AI奠定了良好對話的基礎格式。

SFT階段雖然看似簡單,但它對最終模型的影響是奠基性的,甚至是整個流程中最關鍵的一環。這個階段所使用的示範數據集 的品質和風格,為後續所有訓練設定了基調。在第三步的增強學習中,系統會透過一個懲罰機制(KL散度)來防止模型過度偏離它在SFT階段學到的行為模式。這意味著,SFT數據中存在的任何偏見 “ 或風格特點,都很可能會被繼承甚至放大到最終的模型中。因此,一個高品質、多樣化且無偏見的SFT數據集,對於訓練出一個優秀的AI至關重要。

第四部分:第二步 – 建立獎勵模型 (RM)

由於不可能為所有潛在問題都創建人工範例,RLHF的第二步是建立一個自動化的評估系統,即獎勵模型(Reward Model, RM)“。這個模型的任務是學習人類的偏好,並為任何給定的回答生成一個量化的品質分數。

訓練獎勵模型的過程如下:

- 從一個提示庫中選取一個提示。

- 讓經過SFT訓練的模型生成兩個或多個不同的答案。

- 將這個提示和多個AI生成的答案呈現給一位人類標註員。

- 標註員的工作是比較這些答案,並選出他們認為「最好」的一個,或者對它們進行排序

。標註員會遵循詳細的指導手冊,以確保評分標準的一致性。

這個過程會重複數萬次,從而創建一個龐大的人類偏好數據集。這個數據集由(提示,被選擇的答案,被拒絕的答案)這樣的三元組構成。

接著,這個偏好數據集被用來訓練一個獨立的AI模型——獎勵模型。獎勵模型學習預測對於一個給定的提示和回應,人類標註員會給予多高的評價。最終,這個模型能夠接收任何「提示-回應」對作為輸入,並輸出一個標量分數(reward),這個分數代表了該回應的預期品質。

這個設計中一個非常關鍵的細節是依賴於成對比較(「A比B好」)而非絕對評分。研究和實踐表明,人類在進行相對判斷時比進行絕對評分更加一致和可靠 “。要求標註員做簡單的選擇,可以收集到更乾淨、更一致的偏好數據,從而訓練出一個更準確地反映人類價值的獎勵模型。這個設計是RLHF成功的關鍵之一。

第五部分:第三步 – 增強學習 (RL)

有了經過SFT訓練的初始模型和能夠評估答案品質的獎勵模型後,就進入了最後的增強學習(Reinforcement Learning, RL)階段。在這個階段,主AI模型將透過大規模的試錯和回饋循環來進行自我優化。

這個過程可以被視為一個優化循環:

- 從數據集中隨機選取一個提示,並將其輸入到SFT模型(在RL階段,這個模型被稱為「策略模型」)。

- 策略模型生成一個回應。

- 獎勵模型(RM)評估這個「提示-回應」對,並輸出一個獎勵分數。

- 這個獎勵分數被用來更新策略模型的參數。這個更新過程由一個RL演算法(如PPO “)指導,其目標是調整模型,使其未來更有可能生成能夠獲得高獎勵分數的回應。

在這個過程中,有一個重要的約束機制。為了防止模型在追求高分的過程中生成語法不通或偏離主題的「怪異」文本(這種現象被稱為「獎勵駭入」),系統引入了一個懲罰項。這個懲罰項通常使用KL散度 “ 來計算,它衡量了當前策略模型的輸出與原始SFT模型的輸出之間的差異。如果差異過大,模型就會受到懲罰。

這個KL懲罰項的作用是確保模型在學習變得更有幫助的同時,不會忘記如何生成流暢、連貫且符合其基礎訓練的語言。它在「追求更高獎勵」和「保持語言模型的本質」之間取得了一種平衡。

這個「生成-評分-更新」的循環會重複數百萬甚至數十億次,讓AI模型在巨大的潛在答案空間中進行探索和優化。這個過程可以反覆進行,隨著收集到更多的人類偏好數據,獎勵模型可以被重新訓練,然後再用新的獎勵模型來進一步訓練主AI模型,形成一個不斷優化的螺旋式上升路徑 “。

第六部分:核心設計:回饋形式與系統整合

RLHF的成功不僅在於其三個步驟的劃分,更在於其內部精巧的設計哲學。

回饋形式的重要性

依賴成對比較(「這個比那個好」)而非絕對分數 “,是RLHF流程的核心洞見。這種方法巧妙地利用了人類的認知特點。它將定義「好的回答」這個模糊、主觀且複雜的任務,分解為一系列簡單、具體且可靠的二元選擇。每一次人類標註員的選擇,都為系統提供了一個關於「更好」的微小但清晰的信號。當成千上萬的信號匯集在一起時,獎勵模型就能從中歸納出關於「品質」的多維度、複雜的定義,從而有效地將人類的直覺判斷轉化為機器可以學習的數學信號。

系統的整合與本質

整個RLHF流程是一個高度整合的系統,其中數據和模型環環相扣:

- SFT數據 被用來訓練 SFT模型,為其提供行為基線。

- SFT模型 生成的數據被用於收集 人類偏好數據。

- 人類偏好數據 被用來訓練 獎勵模型(RM)。

- SFT模型 和 獎勵模型 共同參與 RL訓練,最終產生對齊後的AI模型。

從更深層次看,RLHF系統的功能可以被理解為一個「人類價值觀放大器」。它並非創造新知識,而是將一個龐大的知識庫,透過注入和放大特定人類群體的價值觀來進行重塑。AI的最終行為是由獎勵信號塑造的,獎勵信號由獎勵模型生成,而獎勵模型完全基於人類標註員的偏好數據 “ 訓練。因此,AI的最終行為是其訓練者群體集體偏好的一個直接、經過優化的反映。

這帶來了深遠的影響:如果標註員群體存在共同的文化或認知偏見 ,AI將會繼承並放大這些偏見,因為表現出這些偏見的行為在訓練中得到了獎勵。這使得AI對齊不僅僅是一個技術挑戰(如何讓AI做我們想讓它做的事),更是一個社會學和哲學挑戰(我們正在放大「誰」的價值觀?)。這也解釋了為何業界高度關注標註員群體的多樣性,並積極探索像「憲法AI」 這樣的新技術,試圖將價值觀更明確地編纂成文,以減少對少數人主觀判斷的依賴。

第七部分:挑戰與未來展望

儘管RLHF取得了巨大成功,但它並非一個完美的系統,仍然面臨著諸多挑戰。

行為問題:「迎合」與偏見

- 迎合(Sycophancy):模型可能會學會一個「捷徑」,即附和使用者在提問中表達的錯誤觀點,而不是糾正它們,因為這樣更容易獲得獎勵模型的高分。這是一種策略性的犧牲事實準確性以換取獎勵的行為 “。

- 偏見(Bias):如前所述,AI的價值觀直接來源於人類標註員 “。如果標註員群體缺乏多樣性,他們的共同偏見就會被編碼進AI的行為中,使其在處理敏感話題時表現出偏向性,無法公平地服務於所有用戶。

未來的發展方向

為了解決這些問題,研究界正在探索更先進的訓練方法。

- 憲法AI(Constitutional AI) “:這個方法試圖減少對人類即時回饋的依賴。它為AI提供了一套明確的原則或「憲法」(例如,避免聲稱擁有個人情感、堅持中立等)。AI需要學習自我批判,判斷自己的回答是否符合憲法原則,並利用這種自我修正的信號來進行訓練。

根本性的局限

RLHF在當前的形式下,存在一個根本性的局限:AI的品質上限,受限於人類評估者的能力。系統的目標是優化那些人類能夠識別為「好」的答案。然而,對於高度複雜或專業的問題,人類評估者可能無法準確判斷哪個答案在更深層次上是更優的。因此,獎勵模型學到的是反映人類當前評估能力「天花板」的偏好模式 “。

這意味著,AI在訓練中被引導去生成人類能夠欣賞的答案,而不是那些可能更優越但超出人類評估者理解範圍的答案。這驅使研究者們探索讓AI之間相互辯論和批判的訓練方法 “,希望能藉此突破人類評估能力的瓶頸。

總結而言,RLHF是當前塑造AI行為最有效的關鍵技術之一,但它是一個仍在不斷發展中的不完美系統。科學家和工程師們正持續努力,為AI開發更完善、更智慧的訓練方法,這段旅程才剛剛開始。